Narzędzia i serwisy do analizy tekstu

Jednym z serwisów umożliwiających opracowanie, a następnie analizę materiału tekstowego jest LEM (Literacki Eksplorator Maszynowy) (Maryl, Piasecki, i Walkowiak 2018). Jest to serwis opracowany z myślą o przetwarzaniu tekstów literackich w języku polskim, przede wszystkim umożliwiający wydobywanie informacji statystycznych. Zawiera on m.in. moduły służące do przeprowadzenia lematyzacji, wyznaczenie części mowy, przedstawienie charakterystyki czasownikowej korpusu, stworzenie różnego rodzaju list frekwencyjnych, obejmujących zarówno występowanie poszczególnych lematów, jak i tagów morfosyntaktycznych. LEM może także przeprowadzić ujednoznacznianie znaczeń leksykalnych. Z zadań podstawowych dostępna jest też m.in. konwersja pliku do formatu txt.

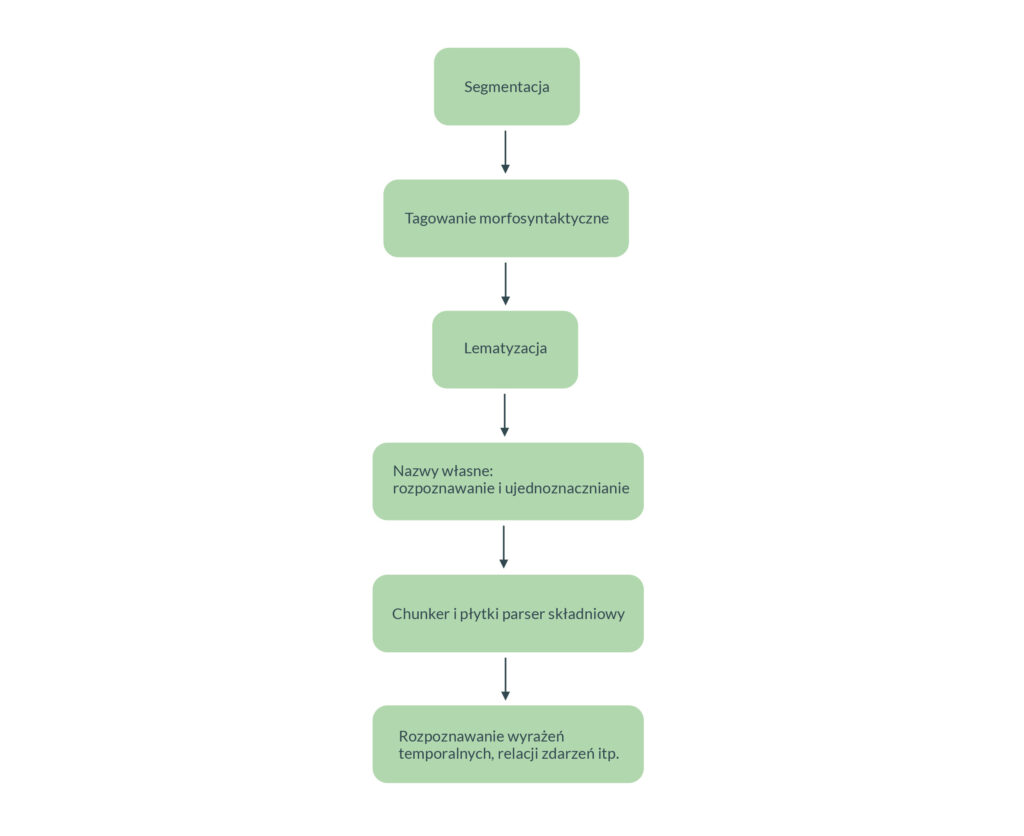

Otagowane i poddane lematyzacji teksty wchodzące w skład korpusu można, z wykorzystaniem odpowiednich narzędzi, poddać procesowi anotacji. Polega on na ręcznym lub automatycznym przyporządkowaniu odpowiednim fragmentom tekstu znaczników, pozwalających na przypisanie określonemu słowu bądź fragmentowi tekstu zdefiniowanych przez anotatora (czyli osobę nanoszącą anotacje) wartości. Infrastruktura CLARIN dysponuje narzędziami, które pozwalają na nanoszenie określonych zestawów anotacji – np. wychwytujących nazwy własne i wyrażenia temporalne – automatycznie. Uważam za wartościowe zaznaczenie w tym miejscu, że system anotacji może dla tradycyjnego literaturoznawcy stanowić odpowiednik papierowych notatek czy „zakładek” umiejscawianych na marginesie tekstu. Ułatwia odnalezienie i zgrupowanie fragmentów oznaczonych tą samą wartością anotacji, umożliwia też wydobycie statystyk dotyczących np. występowania określonego typu anotacji w danej grupie tekstów.

Opracowany materiał tekstowy można następnie poddać zaawansowanej analizie. Dostępnych jest wiele możliwych działań, omówione zostaną przykładowe z nich.

Narzędzia mogą pomóc odnaleźć w tekście określone rodzaje informacji. Wspomniany już wcześniej LEM daje możliwość wygenerowania uporządkowanej listy nazw własnych występujących w danym korpusie. Z kolei Liner 2 (Marcińczuk, Kocoń, i Oleksy 2017) to narzędzie, które może zostać wykorzystane do rozwiązywania różnego rodzaju zadań polegających na etykietowaniu fragmentów tekstu, przede wszystkim do rozpoznawania nazw własnych i wyrażeń temporalnych. Dostępna jest też funkcja, w ramach której na podstawie preprogramowanego słownika oraz analizy połączeń syntaktycznych wyróżnia on w wypowiedzeniu określenia określające czynność od wyrażeń opisujących relacjonowanie tejże czynności.

Ważnym przykładem analizy jest analiza różnego rodzaju cech gramatycznych tekstu. Jest to element wielu już omówionych narzędzi (jak WebSty, KonText, ComCorp czy LEM). Narzędzie Verbs pozwala specyficznie na analizę charakterystyki czasownikowej tekstu, dając w wyniku tabelę ukazującą występowanie czasowników w określonych formach gramatycznych. Do analizy składniowej służą natomiast różnego rodzaju parsery – można wyróżnić parsery wyspecjalizowane w płytkiej bądź głębokiej analizie składniowej.

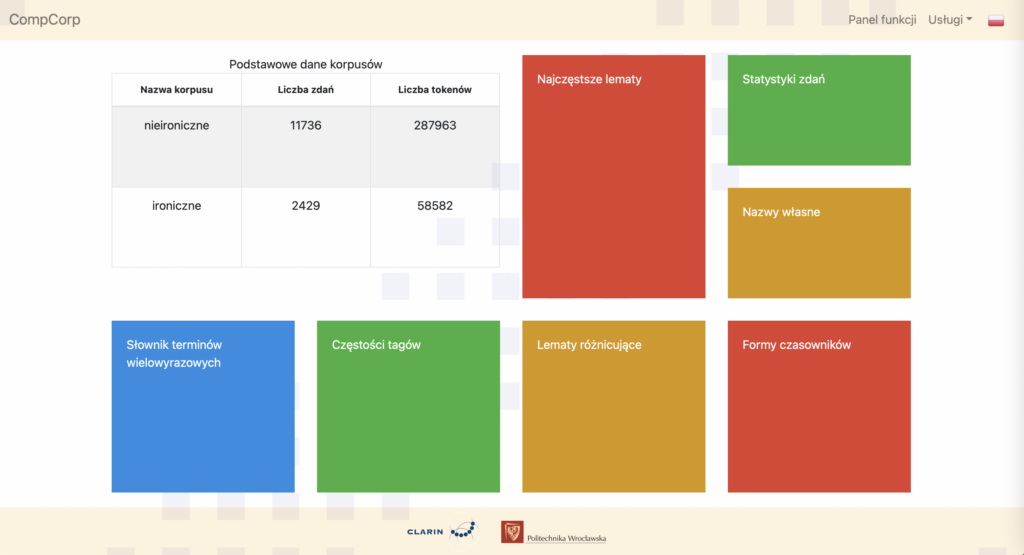

Il. 11 Wyniki porównania dwóch korpusów w serwisie CompCorp, źródło: CompCorp

Budzącym duże zainteresowanie, a także wykorzystywanym komercyjnie zadaniem jest analiza wydźwięku (czy inaczej sentymentu) wypowiedzenia. Służy do niej np. narzędzie Sentemo. Upraszczając, narzędzie to przede wszystkim na podstawie występowania słownictwa o określonym nacechowaniu lub oznaczającego określone stany emocjonalne wyznacza w tekście fragmenty o pozytywnym bądź negatywnym nacechowaniu emocjonalnym. Możliwe jest też odnalezienie słów i wyrażeń oznaczających jedną z określonych emocji. Narzędzia do analizy wydźwięku bywają też wykorzystywane komercyjnie, np. w celu odnajdywania w sieci pozytywnych i negatywnych opinii dotyczących danej firmy czy produktu.

Skomplikowanym rodzajem analizy jest tworzenie sieci relacji między bytami występującymi w tekście. Modułem umożliwiającym ukazanie relacji między bytami dysponuje choćby LEM – w tym przypadku możliwe jest śledzenie relacji między ludźmi, między miejscami lub między organizacjami (nie między bytami różnego typu). W efekcie stworzony zostaje interaktywny graf, w którym ukazane są relacje między poszczególnymi bytami oraz siła tych relacji (stworzona na podstawie występujących w tekście interakcji między nimi).

Istnienie rozbudowanej infrastruktury do NLP umożliwia tworzenie serwisów stanowiących swoistą nadbudowę nad nimi. Takim serwisem jest powstający w ramach DARIAH.Lab GoLEM – Grafowy Literacki Eksplorator Maszynowy, który jest tworzony z myślą o analizie przepływu terminów i idei literackich. GoLEM będzie oferował analizę i wizualizację powiązań między tekstami oraz tworzenie słowozbiorów na kilku poziomach: intertekstualnym, między autorami, między domenami, jak np. między psychologią, filozofią, ekonomią etc, między regionami czy w wymiarach synchronicznym i diachronicznym. Możliwa będzie też analiza zmian pola semantycznego pojęć literackich. Narzędzie będzie dysponowało modułami umożliwiających wykorzystanie metadanych do analizy i grupowania tekstów, rozpoznawanie jednostek nazewniczych poszerzonych o słownictwo literaturoznawcze, analiza relacji między bytami, a także modelowanie tematyczne. GoLEM będzie działał na korpusie dostarczonym przez swoich twórców, zawierającym wybrane teksty literaturoznawcze, w tym z zakresu krytyki literackiej.